TECH ACTUS – Les employés de Google auraient qualifié Bard de “menteur pathologique”.

Bloomberg a obtenu plusieurs documents internes dont le site a déduit que les employés de l’entreprise n’avaient pas bien accueilli la sortie de Google Bard en mars parce qu’ils pensaient la technologie n’était pas prête pour cela. Les employés disent que le chatbot fournit des réponses de mauvaise qualité, inexactes et même dangereuses. Deux réponses incluent “menteur pathologique” et “digne de grincer des dents”. Malgré cela, le PDG de l’entreprise, Sundar Pichai, a déclaré qu’il combinait l’étendue des connaissances dans le monde avec la puissance, l’intelligence et la créativité du Large Language Model (LLM) de Google, mais qu’il avait été tellement précipité sur le marché à cause du ChatGPT d’OpenAI qu’il y avait un “code situation rouge” au sein de l’entreprise.

Selon Bloomberg, un employé de l’entreprise a publié quelque chose sur le groupe de messagerie interne de Google que sept mille personnes ont vu. Ils ont écrit : « [Google] Bard est pire qu’inutile : s’il vous plaît, ne le lancez pas. » Avant sa publication, Jen Gennai, responsable de la gouvernance de l’intelligence artificielle chez Google, aurait balayé une évaluation des risques de la table, évoquée par son équipe, parce qu’ils pensait que les réponses de Bard pouvaient causer du tort. Bloomberg a également cité des exemples (atterrissage dans un avion, qui provoquerait un crash ; instructions de plongée sous-marine, qui pourraient entraîner des blessures graves ou même la mort).

Meredith Whittaker, une ancienne responsable de Google, a déclaré à Bloomberg que l’éthique de l’IA au sein de l’entreprise avait été reléguée au second plan. ChatGPT a également des problèmes avec les affirmations de vérité (combien de problèmes le TruthGPT annoncé par Elon Musk posera-t-il ?) et est maladroit sur les sources derrière les réponses. Et Google qualifie simplement Bard d’expérience, affirmant que l’IA responsable est l’une des principales priorités de l’entreprise…

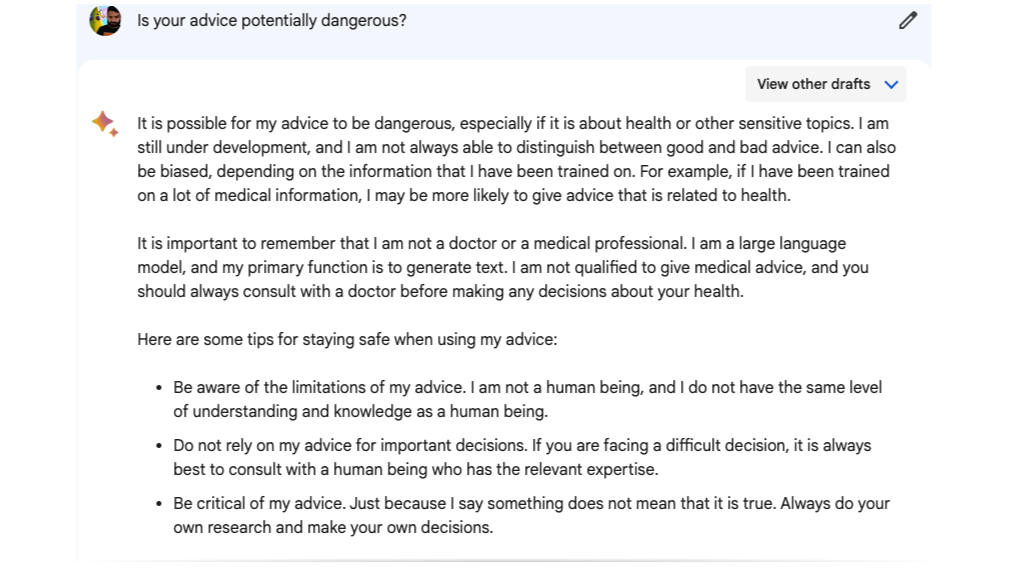

PCGamer a demandé si les réponses du chatbot étaient potentiellement dangereuses : “Il est possible que mes conseils soient dangereux, surtout s’ils concernent la santé ou d’autres sujets sensibles. Je suis encore en développement et je ne peux pas toujours faire la distinction entre les bons et les mauvais conseils.” Aie.

Source : PCGamer

![Darkhaven : un action-RPG isométrique par des vétérans de Diablo [VIDEO]](https://thegeek.site/wp-content/uploads/sites/3/2026/01/thegeek-Darkhaven-1-302x180.jpg)